1. El análisis debe coincidir con las observaciones

- El concepto equivocado

- Datos observados frente a resolución y física del modelo: Datos observados

- Datos observados frente a resolución y física del modelo: Explicación de las discrepancias

- Asimilación cíclica

- Cómo se toman en cuenta estos factores

- Ponga a prueba sus conocimientos

- La realidad

1. El análisis debe coincidir con las observaciones » El concepto equivocado

Podríamos suponer que para generar el mejor pronóstico posible con un sistema de predicción numérica del tiempo, o PNT, el análisis inicial del modelo debe coincidir a la perfección con las observaciones empleadas en dicho análisis. Estaríamos suponiendo mal.

¿Qué hay detrás de este concepto equivocado y contrario a la intuición? Vamos a ver.

El análisis inicial es el resultado de una complicada combinación de las observaciones y un pronóstico a corto plazo generado por el modelo al que denominamos campo de prueba (o primera aproximación), cuyo objetivo es brindar el mejor punto de partida posible para el modelo de pronóstico. El análisis debe tener en cuenta factores tales como el distinto grado de precisión de los diversos sistemas de observación empleados, la posibilidad de que algunas observaciones sean incorrectas y la importancia relativa del campo de prueba y de las observaciones. El análisis debe además ser coherente con la resolución y con la física del modelo. Por estos motivos, el análisis inicial del modelo diferirá en cierta medida de las observaciones.

1. El análisis debe coincidir con las observaciones » Datos observados frente a resolución y física del modelo: Datos observados

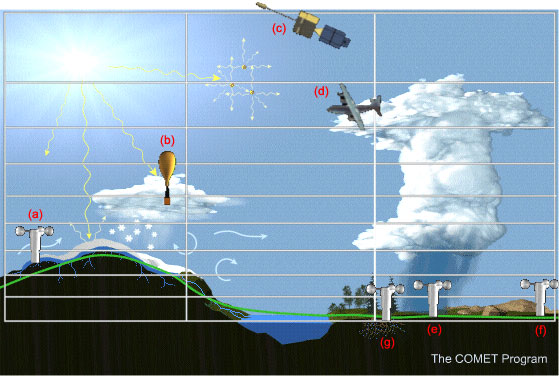

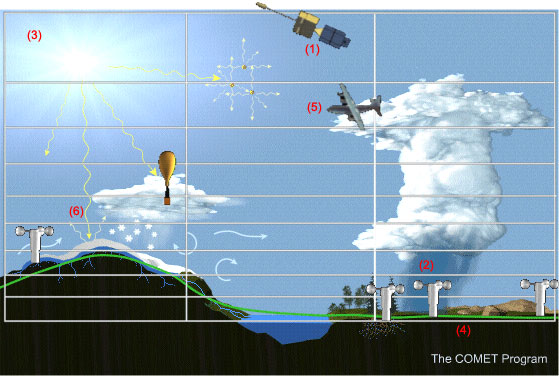

Para ilustrar por qué esto es así, consideremos el ejemplo de una malla de modelo en la cual, como es normal, se realizan varios tipos distintos de observaciones. Esta figura muestra una sección vertical, bidimensional, de la malla de un modelo tridimensional; como podemos ver, la malla se compone de una multitud de celdas rectangulares. Dentro del área de muestreo comprendida por la malla encontramos varios sistemas de observación distintos:

(a) Un sistema de observación en superficie (como los que forman parte de la red sinóptica) con un gradiente de escala inferior a la malla en cuanto a manto de nieve, topografía y temperatura de superficie.

(b) Una radiosonda atraviesa un chubasco de nieve de escala inferior a la malla.

(c) Un satélite que mide una radiancia específica de una capa atmosférica que es más gruesa que la altura de las celdas individuales de la malla.

(d) Un avión que mide vientos de escala inferior a la malla a la altura del yunque de un cumulonimbo.

Hay tres otros puntos de observación superficial, todos dentro de la misma celda de la malla:

(e) en la zona debajo de la lluvia convectiva;

(f) en la zona antes de la actividad convectiva, delante de la nube;

(g) en la zona después de la actividad convectiva, detrás de la nube.

Por lo general, la resolución de las observaciones en la atmósfera real difiere de la resolución del modelo, lo cual significa que las características que el modelo puede resolver "difieren" en cierto sentido de las que pueden resolver los sistemas de observación.

1. El análisis debe coincidir con las observaciones » Datos observados frente a resolución y física del modelo: Explicación de las discrepancias

En algunos casos, el modelo es incapaz de resolver ciertas características que, no obstante, se pueden detectar mediante las observaciones. En otras situaciones, el volumen muestreado por el sistema de observación es mayor que la celda de la malla que el modelo puede resolver. Es más, no debemos olvidar que el campo de prueba se usa siempre en el análisis. Esencialmente, el análisis considera que el campo de prueba es otro tipo de datos cuyos valores están disponibles en la totalidad de la malla tridimensional.

Consideremos algunas de estas ideas más a fondo:

(1) Resolución de la muestra en la atmósfera frente a resolución del modelo:

El satélite mide las radiancia media en una capa profunda de la atmósfera, mientras que la resolución vertical del modelo excede la capacidad de percepción del satélite.

(2) Coherencia con la física del modelo:El análisis agrega humedad para reflejar la humedad observada en un sitio tal como el que se encuentra en el chubasco. No obstante, si la atmósfera del modelo tiende ser excesivamente seca, el modelo simplemente precipitará mucha humedad en los primeros intervalos de tiempo para ajustarse al nivel de sequedad que requieren sus propios parámetros físicos.

(3) Celdas de malla sin datos observados:Habrá numerosas celdas en la malla sin ningún dato observado que se pueda aplicar al análisis , como, por ejemplo, sobre los océanos, en las regiones polares y a gran altura en la atmósfera. El análisis rellena estas faltas de datos con los valores del campo de prueba.

(4) Observaciones incorrectas o en conflicto:Sí, hay que admitir que a veces algunas observaciones son incorrectas, y el análisis puede o no rechazarlas, según los criterios de rechazo empleados. Es fácil identificar y rechazar las observaciones que son claramente incorrectas, pero es más difícil encontrar los errores menores. Incluso cuando los datos observados son correctos, es fácil que haya datos en conflicto dentro de una sola celda de la malla. Por ejemplo, las tres observaciones alrededor del chubasco se hallan en la misma celda de la malla, pero a los fines del análisis entran en conflicto, ya que miden fenómenos de escala inferior a la malla.

(5) Error de observación:Hay un grado de error de observación inherente a todo sistema de observación. Algunos sistemas producen errores mayores que otros, de modo que el análisis da más o menos peso a las observaciones de los diferentes sistemas de observación. De hecho, se ignoran las observaciones cuya magnitud de error se considera lo suficientemente grande, de modo que no influyen en absoluto en el análisis.

(6) Estructura vertical:La estructura vertical de los sistemas meteorológicos se debe representar correctamente en el análisis. Supongamos que nuestras observaciones superficiales muestran la presencia de un centro de baja presión, sin los correspondientes datos de los niveles altos. La inclusión de las observaciones superficiales en el análisis sin otros datos puede llevar a un pronóstico poco confiable, ya que en ese caso el modelo tiende a debilitar la baja si sus condiciones iniciales no definen la estructura de apoyo en altura.

Relaciones entre masa y viento:Las relaciones entre masa y viento son de suma importancia en el análisis, porque determinan el movimiento ageostrófico, que a su vez puede estar relacionado con importantes movimientos verticales. El campo de masa observado, representado por alturas geopotenciales, define el viento geostrófico que, una vez restado del viento realmente observado en el mismo lugar, produce el viento ageostrófico en ese sitio. Por tanto, la relación entre masa y viento se define mejor a partir de observaciones independientes, pero tomadas en el mismo lugar. Las radiosondas proporcionan este tipo de observación en cualquier columna atmosférica. Los satélites, por otra parte, solo proporcionan observaciones de masa donde el cielo está despejado y observaciones de viento solo en el nivel de las cimas de las nubes, donde es posible hacer el seguimiento del movimiento de las nubes. Estas observaciones no se realizan en el mismo lugar.

En resumidas cuentas, para producir el análisis objetivo se combinan varios tipos de datos de distintas características y coberturas geográficas con el campo de prueba. Conviene saber cómo el análisis ha sido afectado por la presencia (o ausencia) de los distintos tipos de datos meteorológicos y por la calidad del campo de prueba: es poco probable que se genere un buen pronóstico si el análisis inicial es débil.

1. El análisis debe coincidir con las observaciones » Asimilación cíclica

No es posible obtener un análisis meteorológico de buena calidad sin incorporar la asimilación cíclica. En este proceso, el análisis combina un pronóstico a corto plazo del modelo (el campo de prueba o de primera aproximación) con todas las observaciones disponibles: en la práctica, se utilizan las observaciones para hacer pequeñas correcciones en el pronóstico a corto plazo.

Vamos a utilizar el gráfico que aparece a continuación para ilustrar el proceso de asimilación cíclica. El eje vertical muestra el estado de una variable atmosférica en particular (temperatura, viento, etc.) en determinado punto de malla, mientras que el eje horizontal muestra el tiempo. Por lo tanto, el gráfico ilustra la evolución de la variable a lo largo del tiempo.

La línea roja indica el «verdadero» o «mejor» estado de la variable en el análisis dadas la resolución y física del modelo. La región color rosa representa la «zona de la verdad», que corresponde al rango admisible de valores dados la densidad y los errores de observación.

Antes de cada período de análisis, el modelo genera un pronóstico a corto plazo válido para el momento del análisis. Este es el campo de prueba. Debido a que los valores pronosticados por el modelo para las variables del campo de prueba cambian con el tiempo, pueden salir de la "zona de la verdad". El análisis debe usar los datos observados para reincorporar cada variable al rango aceptable y generar un análisis inicial que pueda servir como base para el próximo pronóstico del modelo.

Una de las principales ventajas de la asimilación cíclica es que permite retener la información útil de los análisis previos y conservarla para los pronósticos posteriores. Esto es particularmente importante en las áreas para las cuales se cuenta con pocos datos. Por ejemplo, para una zona en el medio del océano podríamos contar con un par de informes marinos a las 12 UTC que definen una zona de baja presión. Esta información se lleva hacia adelante a las 18 UTC por medio del campo de prueba. Si no se cuenta con ninguna observación para esa zona a las 18 UTC, el análisis procederá, «consciente» de la existencia de la baja gracia al procedimiento de asimilación cíclica. Esto significa que el análisis depende en cierta medida de la calidad del modelo de PNT empleado para crear el campo de prueba. Si el pronóstico a corto plazo no es muy bueno, es posible que las correcciones realizadas por el análisis no sean suficientes para reincorporar las variables del modelo a la «zona de la verdad». A su vez, esto puede llevar a la generación de otros pronóstico inadecuados.

En fin, el proceso de asimilación cíclica ha sido diseñado para crear una representación cuatridimensional del estado de la atmósfera en la cual los valores analizados de las variables atmosféricas son coherentes con los parámetros físicos, dinámicos y numéricos del modelo de PNT empleado en dicho proceso. El objetivo es extraer tanta información aprovechable como sea posible de las observaciones disponibles, pero evitando a la vez la información incoherente que pueda deteriorar el análisis.

1. El análisis debe coincidir con las observaciones » Cómo se toman en cuenta estos factores

Consideremos ahora un ejemplo de cómo se utilizan las observaciones para corregir el campo de prueba durante el proceso de análisis. En esta carta, las barbas negras representan los vientos cambiados por el análisis del campo de prueba de vientos de 250 hPa como resultado de haber tomado en cuenta las observaciones disponibles.

La diferencia entre los vientos observados y el campo de prueba se puede también calcular. Estas diferencias se trazan como barbas rojas en cada sitio de observación.

Si el análisis coincidiera a la perfección con las observaciones, las barbas de vientos rojas y negras coincidirían perfectamente. En la práctica, esto rara vez sucede, el análisis más bien peca por corregir menos de lo que podría. Por lo general, los cambios realizados en el campo de prueba tienden hacia el viento observado, tanto en cuanto a velocidad como a dirección, pero son menores de lo que sería necesario para que coincidan perfectamente con las observaciones.

Por ejemplo, podemos ver que la velocidad del viento se ha corregido menos de lo que se hubiera podido, pero que la corrección es hacia el valor observado en las estaciones de Omaha, Minneapolis, Amarillo, Midland y Little Rock (los círculos azules).

Considere ahora el caso de Peach Tree City, cerca de Atlanta (el círculo amarillo), donde ocurrió algo inusual: la observación muestra que el campo de prueba estaba equivocado a razón de 50 nudos. Esta diferencia es muy grande y, por tanto, el análisis supuso que la observación era incorrecta y la ignoró. Como resultado de esto, la corrección del campo de prueba muestra un viento ligero en la dirección opuesta a la observación.

Este tipo de situación es poco común. Si la observación es correcta, el análisis será incorrecto y puede producir un error de pronóstico. En este caso en particular los modelos de PNT no pronosticaron la tormenta de nieve que se produjo después de la hora del análisis.

Sin embargo, normalmente el análisis emplea las observaciones en el análisis con las correcciones antes descritas. Esto puede tener implicancias importantes para los sistemas en rápida fase de evolución o para los sistemas que entran en la red de radiosondas por primera vez, como los que llegan a la costa oeste de EE. UU. desde el Pacífico. A menudo, el campo de prueba subestima la verdadera intensidad de dichos sistemas, de modo que puede pasar varios ciclos de asimilación antes de que el análisis alcance su verdadera estructura.

1. El análisis debe coincidir con las observaciones » Ponga a prueba sus conocimientos

En la lista siguiente, elija los procedimientos que serían útiles para evaluar las condiciones iniciales del modelo.

Explicación:

Las respuestas correctas están a), c), d) y e)

a) Debido a que el campo de prueba forma parte integral del análisis, sus debilidades se reflejarán en el análisis, especialmente en las zonas para las cuales se cuenta con pocos datos.

b) Aunque muchos de los casos de rechazo de datos se deben a observaciones incorrectas, es también posible que el análisis rechace observaciones correctas.

c) Los patrones en las imágenes de satélite reflejan las condiciones atmosféricas actuales, de forma que la comparación de las imágenes con el análisis puede contribuir a determinar si el análisis está encaminado hacia la solución correcta.

d) Suponiendo que las observaciones son correctas, la existencia de grandes diferencias entre el análisis y las observaciones indicará la presencia de áreas en la atmósfera cuya estructura no está bien definida en el análisis.

e) Los modelos numéricos de alta resolución pueden producir características espurias a una escala menor que la red de observaciones. Estas características pueden aparecer en el análisis a través del campo de prueba y su presencia puede contaminar el pronóstico posterior del modelo de PNT.

f) El análisis debe conservar su coherencia interna con los parámetros físicos, dinámicos y numéricos del modelo empleados en el proceso de asimilación. Por definición, el modelo no puede resolver los procesos de escala inferior a la malla, de modo que normalmente el análisis no conservará los detalles de estos procesos. Claramente, debemos estar conscientes de la falta de dichos detalles al emitir un pronóstico a corto plazo.

g) Las diferencias grandes en las observaciones pueden deberse a una o más observaciones incorrectas. Si las observaciones son correctas, es probable que las diferencias se deban a la medición de características de pequeña escala que no son representativas del promedio de la celda de la malla. En ambos casos, el análisis se produce de acuerdo con sus propias reglas que rigen el rechazo de los datos y el uso de las observaciones y el campo de prueba. Aunque en estos casos el análisis puede tener ciertas debilidades, puede también producir la mejor representación posible de la atmósfera dados los parámetros dinámicos, físicos y numéricos del modelo.

1. El análisis debe coincidir con las observaciones » La realidad

Suponer que el análisis debe coincidir con las observaciones es un concepto equivocado.

Resumen:

- El análisis inicial no debe necesariamente ser idéntico a las observaciones.

- Se dan casos en los que las observaciones pueden resolver fenómenos atmosféricos que el análisis no puede discernir.

- El modelo de PNT proporciona los datos para el análisis a través del campo de prueba en el proceso de asimilación cíclica.

- En la mayoría de los casos, el análisis corrige las discrepancias entre las observaciones y el campo de prueba meno de lo que podría.

- Por lo general, las observaciones con grandes discrepancias se ignoran. En los muy raros casos en que tales observaciones son correctas, el hecho de ignorarlas puede producir un pronóstico de calidad inferior.

Es importante tener en cuenta estas características de los procesos de asimilación y análisis a la hora de evaluar la guía de pronóstico del modelo numérico.

Para aprender más acerca de este tema, consulte Comprensión de los sistemas de asimilación: cómo los modelos crean sus propias condiciones iniciales, versión 2, una lección sobre la asimilación de los datos y las condiciones iniciales del modelo que forma parte del curso de aprendizaje a distancia sobre la PNT.

2. La alta resolución lo arregla todo

- El concepto equivocado

- La malla y la resolución del campo geofísico pueden afectar al pronóstico

- ¿Cuándo contribuye una mayor resolución a un mejor pronóstico de precipitación?

- ¿Garantizan mejores pronósticos los modelos de mesoescala?

- Ponga a prueba sus conocimientos

- La realidad

2. La alta resolución lo arregla todo » El concepto equivocado

En nuestros esfuerzos por generar el mejor pronóstico posible, podríamos suponer que lo más importante es ejecutar siempre el modelo de PNT a la mayor resolución posible, ya que esto siempre permitiría generar pronósticos de gran escala y mesoescala más exactos, ¿no es cierto? Y estos incluirían predicciones cuantitativas de la precipitación (PCP) muy exactas y detalladas, ¿verdad?

No, no es así.

Este es un concepto equivocado muy difundido acerca de los modelos de predicción numérica del tiempo. El hecho de ejecutar un modelo con una malla de 2 kilómetros no necesariamente nos ayuda a predecir en qué regiones específicas habrá convección mejor que un modelo con una malla de 80 km. Es más, a veces el modelo de alta resolución puede incluso empeorar el pronóstico de la precipitación u otro fenómeno atmosférico. Vamos a ver si algunos ejemplos pueden ayudarnos a comprender por qué este es un concepto equivocado.

2. La alta resolución lo arregla todo » La malla y la resolución del campo geofísico pueden afectar al pronóstico

Un episodio de nieve ocurrido en el sur de la región de Nueva Inglaterra el 30 de diciembre de 2000 nos permitirá demostrar que el hecho de ejecutar un modelo de alta resolución no siempre produce el mejor pronóstico cuantitativo de la precipitación (PCP).

La verificación de la precipitación total generada por esta tormenta muestra que hubo una zona de nieve muy fuerte en el sur del estado de Nueva York y en el norte de Nueva Jersey, donde se registraron cantidades en equivalente de agua líquida en el rango de 25 a 38 mm (1 a 1,5 pulgadas). Hubo incluso algunas pequeñas áreas en el sur de Nueva York donde las cantidades máximas de nieve observadas dieron un equivalente líquido superior a 38 mm.

El modelo AVN, que tiene una resolución horizontal de 80 km, pronosticó acumulaciones en equivalente de agua líquida en el rango de 25 a 38 mm (1 a 1,5 pulgadas) centradas en la zona oeste de Long Island. Aunque este modelo se acercó al resultado correcto, pronosticó la zona del evento demasiado al sur y al este.

El modelo ETA, con una resolución horizontal de 22 km, colocó el área de mayor precipitación incluso más al sur que el modelo AVN. Si comparamos los dos pronósticos con la verificación, queda claro que en este caso el modelo AVN generó un mejor pronóstico cuantitativo de la precipitación que el modelo ETA, pese a que el modelo ETA tenía casi cuatro veces la resolución que el modelo AVN.

¿A qué se debe este resultado? Para encontrar una respuesta a esta pregunta, consideremos el mismo evento a la luz de un modelo ETA experimental que incorpora un análisis de alta resolución de la temperatura de la superficie del mar (TSM). Podemos ver que el PCP del modelo experimental es mucho mejor que el del modelo ETA operacional.

El modelo ETA con el análisis operacional de TSM de resolución más baja no pudo generar resultados tan buenos como el modelo AVN. El pronóstico del modelo ETA solo mejoró con el uso valores de TSM de resolución más alta que se acercaban a la resolución de malla del modelo ETA. La información adicional contribuyó a producir un mejor pronóstico cuantitativo de la precipitación. Pero dado que la resolución del modelo AVN se acercaba más a la del análisis de TSM de resolución más baja, en este caso hubiera sido mejor confiar en los resultados del pronóstico cuantitativo de la precipitación generados por este modelo, pese a la mayor resolución del modelo ETA operacional.

En resumidas cuentas, en este caso la mayor resolución del modelo no pudo generar un mejor pronóstico. Al contrario, simplemente logró aumentar la sensibilidad del modelo ETA a la temperatura de la superficie del mar. La aplicación de una TSM de mayor resolución afectó al pronóstico cuantitativo de la precipitación generado por el modelo ETA de forma muy positiva. Por otra parte, debido a su menor resolución, el modelo AVN dio resultados razonablemente buenos con el análisis operacional de TSM de menor resolución.

2. La alta resolución lo arregla todo » ¿Cuándo contribuye una mayor resolución a un mejor pronóstico de precipitación?

Consideremos ahora un escenario en el cual un modelo de mayor resolución sí conduce a un mejor pronóstico de la precipitación.

Esta situación ocurrida el 23 de febrero de 1998 presenta el potencial de crecidas en el sur de California, a medida que un fuerte flujo marino alcanza una barrera topográfica. En ciertas partes de los condados de Los Ángeles, Ventura y Santa Bárbara se observó una lluvia muy fuerte, registrándose más de 200 mm (8 pdas.) y, en ciertas zonas, más de 300 mm (12 pdas.) de lluvia.

Si comparamos los pronósticos cuantitativos de la precipitación (PCP) generados por los modelos ETA de 29 y de 10 km con las cantidades de precipitación observadas, notamos en seguida que el PCP del modelo de mayor resolución se aproxima más al mapa de la verificación.

¿Por qué? En el ejemplo anterior vimos que una mayor resolución no condujo a un mejor pronóstico.

La respuesta tiene que ver con la resolución de la topografía y el hecho de que en este caso se trata de la interacción entre un flujo de escala sinóptica bien pronosticado y dicha topografía. Este es un escenario del mejor caso posible para aprovechar al máximo un modelo de mayor resolución. Si consideramos con cuidado la topografía del modelo (las líneas grises en los dos mapas de pronóstico), queda claro que se ve mucho más detalle a 10 que a 29 km de resolución.

En ambos casos la topografía fuerza el movimiento vertical y, por lo tanto, causa la precipitación en el fuerte flujo desde el suroeste, pero el grado de forzamiento es distinto según los detalles de la topografía. El modelo de resolución más alta localiza mucho mejor las áreas de mayor precipitación. Aunque las cantidades pronosticadas siguen siendo menores que la precipitación que ocurrió en la realidad (a razón de hasta 100 mm en algunos casos), las áreas de lluvia más fuerte se aproximan bastante al patrón observado. El pronóstico generado con el modelo de resolución de 10 km es muy útil.

En esta situación, un flujo con fuerte forzamiento sinóptico se desplaza encima de una topografía muy bien definida. Es más, no hay ningún efecto secundario importante, como circulaciones de valle y montaña o de brisa marina. Dadas estas circunstancias, en términos generales podemos esperar que un modelo de mayor resolución pueda generar un pronóstico de precipitación más preciso.

2. La alta resolución lo arregla todo » ¿Garantizan mejores pronósticos los modelos de mesoescala?

La comunidad científica tiene acceso a modelos de PNT modernos de muy alta resolución que incorporan parámetros de microfísica muy avanzados. ¿Obtendríamos automáticamente mejores pronósticos mediante el uso operacional de dichos modelos?

Para considerar un ejemplo de esta posibilidad, estudiaremos el resultado generado en retrospectiva por un modelo de alta resolución para un evento de clima violento de verano que generó un tornado cerca de Oklahoma City en mayo de 1999.

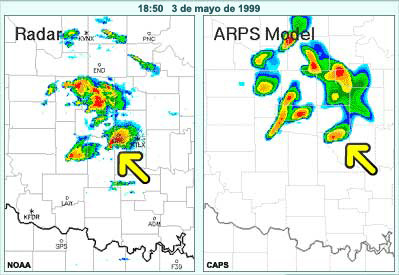

Esta secuencia de imágenes presenta las reflectividades del radar observadas la tarde del 3 de mayo entre las 17:10 y las 20:50 horas junto con las reflectividades simuladas por el modelo para esos mismos momentos sobre la base del modelo ARPS no operativo. Este modelo, que tiene una resolución horizontal de 3 km, toma en cuenta la microfísica del hielo e incorpora varios otros componentes avanzados. El modelo se inicializó con los datos del radar obtenidos después de la formación de las primeras células convectivas, más temprano en el día.

El pronóstico del modelo y las observaciones se asemejan en términos del área general donde se produce la convección. Sin embargo, si consideramos con cuidado las imágenes individuales prestando particular atención las fronteras entre los condados, podemos ver que el modelo no es exacto en su representación de los detalles de posición e intensidad de la convección. Dichos detalles son necesarios para generar avisos exactos.

Por ejemplo, a las 18:50 se está desarrollando un tornado cerca de este notable eco en forma de gancho, pero el modelo ARPS muestra que la célula está debilitándose y que ya se ha desplazado más al noreste.

Claramente, los modelos de alta resolución como el ARPS no producen siempre un mejor pronóstico. Un motivo práctico es simplemente la disponibilidad en el momento oportuno: la salida de dichos modelos no está disponible con suficiente rapidez para que resulte útil al formular el pronóstico. Por ejemplo, en este caso fue preciso inicializar el modelo con los datos de radar correspondientes al desarrollo inicial de las células, pero el pronóstico que generó no estuvo disponible sino mucho más tarde.

Más importante aún, sin embargo, es la necesidad de reconocer las limitaciones básicas inherentes a los modelos de muy alta resolución. Los datos de las observaciones empleados por dichos modelos no están siempre disponibles a la resolución necesaria, lo cual significa que a veces el análisis inicial puede «llenar los vacíos» con detalles incorrectos. Por otra parte, para obtener un pronóstico correcto de la actividad convectiva es preciso que la estructura atmosférica empleada en el modelo sea «perfecta». Esto incluye la humedad atmosférica, que aparte de ser muy variable es difícil de analizar. Además, no es suficiente contar con una estructura perfecta de la atmósfera superior en el modelo: las variables y los procesos de capa límite y de superficie, como temperatura, humedad, mezcla, vegetación, tipos de suelo y evaporación, determinan en parte la inestabilidad y, por consiguiente, el desarrollo de la convección. Aunque estos factores se modelan en mayor o menor medida, es posible que un modelo dado no incluya un tratamiento pleno de todos estos elementos. Finalmente, es poco probable que se obtengan representaciones numéricas perfectas de los procesos de precipitación a través de los paquetes de física de los modelos. Por ejemplo, el modelo puede no detectar los límites de las corrientes de salida, que a menudo inician nueva convección. Por estos motivos, no hay garantía de que ningún modelo, incluso los de muy alta resolución, pueda pronosticar la precipitación convectiva en el área general correcta, pero suponiendo que llegara a hacerlo, es poco probable que maneje correctamente todos los detalles de posición e intensidad de la convección.

Limitaciones de los modelos de alta resolución:

- El análisis puede llenar los «vacíos» en los datos con detalles incorrectos.

- Generar un pronóstico de convección correcto depende de una representación exacta de los parámetros de la atmósfera superior, algunos de los cuales son muy variables y, por tanto, difíciles de analizar.

- Es posible que ciertas variables importantes de la capa límite y de la superficie no se representen bien en el modelo.

- Es poco probable que los procesos de precipitación se representen a la perfección.

2. La alta resolución lo arregla todo » Ponga a prueba sus conocimientos

¿Cuáles de los siguientes enunciados resumen una idea que convendría recordar de la discusión acerca de este concepto equivocado? Elija todas las opciones pertinentes.

Explicación:

Las respuestas correctas están b) d) y e)

a) Un flujo de gran escala puede estar bien definido incluso con datos de baja resolución. Tales flujos pueden interactuar con la topografía detallada de un modelo de mesoescala para producir pronósticos más exactos de vientos y precipitación de lo que sería posible obtener con modelos de resolución más baja.

b) Las características bien definidas, como la temperatura de superficie del mar o la vegetación, pueden afectar al pronóstico a una escala que un modelo de mayor resolución puede manejar; estas características bien definidas se pierden en los análisis de resolución más baja.

c) Si el proceso de asimilación maneja correctamente las característica de menor escala y si la física del modelo es adecuada para dichas escalas, entonces es posible que el modelo de alta resolución produzca un mejor pronóstico.

d) El terreno influye directamente en ciertas variables, como la precipitación y el viento. Claramente, si el modelo incorpora una descripción más detallada del terreno, en ciertas situaciones puede interactuar con el flujo atmosférico para producir un mejor pronóstico.

e) El uso de más datos significa que el análisis tarda más tiempo en ejecutarse. Si aumentamos la resolución horizontal y vertical, tendremos que reducir el intervalo de tiempo considerado por el modelo y el tiempo de ejecución del modelo aumentará, debido a la mayor resolución espacial y temporal. Finalmente, una salida de mayor resolución implica archivos más grandes y, por tanto, una diseminación más lenta de la información.

2. La alta resolución lo arregla todo » La realidad

Ejecutar los modelos a la mayor resolución NO SIEMPRE permite generar pronósticos más exactos.

Uno de los principales aspectos que hay que tener presentes es que todos los componentes del modelo funcionan en sinergia. Esto significa que la mayor resolución funciona mejor si el modelo también incorpora paquetes de física mejores y más realistas, así como más detalles en las especificaciones de superficie de los campos, tales como suelo, vegetación, temperatura de superficie del mar y topografía. Es también necesario contar con datos de alta resolución, y el sistema de asimilación de los datos debe manejar dichos datos correctamente a la resolución del modelo. De hecho, es probable que los datos y su asimilación sean los factores más importantes para obtener mejores pronósticos de los modelos de PNT de alta resolución.

Resumen:

- El modelo debe poder aprovechar los campos de superficie a una resolución comparable a la de la

malla.

- Se deben incorporar paquetes de física realistas en el modelo.

- Es sumamente importante contar con datos de alta resolución y con una asimilación correcta de los datos.

Para aprender más acerca de este tema, consulte la lección Fundamentos de los modelos: versión 2, que forma parte del curso de educación a distancia sobre la PNT, y la Enciclopedia de Modelos Operativos (Operational Models Encyclopedia).

3. Una malla de 20 km representa con precisión

las características de 40 km

- El concepto equivocado

- Resolución de características de pequeña escala

- Los fenómenos atmosféricos como ondas

- Características de escala más grande en los modelos numéricos

- El concepto de degradación

- Ponga a prueba sus conocimientos

- La realidad

3. Una malla de 20 km representa con precisión las características de 40 km » El concepto equivocado

Con la ayuda de un modelo de alta resolución es posible aumentar la probabilidad de generar el pronóstico perfecto, incluso para los fenómenos de pequeña escala. Por ejemplo, los modelos de alta resolución nos ayudan a localizar con exactitud el lugar donde se producirá la mayor concentración de nieve por efecto lago y nos proporcionan pronósticos exactos de los efectos de los vientos orográficos sobre las temperaturas regionales, ¿no es así?

Pero, ¡un momento! Estas ideas son el resultado de un concepto equivocado común acerca de los pronósticos de PNT.

Las características que abarcan solo 2 o 3 puntos de malla no se resuelven bien en ningún modelo numérico. Un modelo de alta resolución con una malla de 20 km no puede resolver con precisión una característica de 40 km. Es más, para que pueda dar resultados adecuados, el modelo va a necesitar una resolución inferior a 10 km, e incluso con esa resolución una representación exacta de la característica no durará mucho en el pronóstico.

3. Una malla de 20 km representa con precisión las características de 40 km » Resolución de características de pequeña escala

Vamos a ver como un modelo de alta resolución resuelve algunas características típicas de pequeña escala.

La ilustración que sigue representa una zona de convergencia/divergencia asociada a un frente frío. La distancia entre los puntos de la malla, ΔX, es de 50 km. Las nubes asociadas con la extensa región de convergencia en los niveles inferiores (característica A) aparecerán en los campos del modelo. Sin embargo, ciertas características más pequeñas de la región de divergencia, como las características B, abarcan menos de 4 puntos de malla y no se resolverán adecuadamente.

Aunque las características de la zona de convergencia se traspasan a la malla de 50 km, esto no significa que estarán bien resueltas ni que su evolución se pueda pronosticar con precisión. Vamos a ver por qué estas características representarían un reto incluso para un modelo con una malla de 20 km.

3. Una malla de 20 km representa con precisión las características de 40 km » Los fenómenos atmosféricos como ondas

En los modelos numéricos, los fenómenos atmosféricos se pueden representar como ondas. Esta es la representación simplificada a 4 ΔX de un ciclo de la onda sinusoidal que corresponde a una banda de precipitación frontal observada asociada con una zona de convergencia/divergencia.

Los rombos azules muestran el valor promedio de la característica representada en cada celda de la malla y la línea amarilla muestra cómo se representa en el modelo.

El tamaño de la característica en relación con la malla es 4 ΔX. En este ejemplo, ΔX equivale a 20 km, es decir, la resolución del modelo en términos de la distancia entre puntos de la malla. La característica tiene una longitud de 80 km y se representa como una onda 4 ΔX.

Se nota en seguida que la onda del modelo (la línea amarilla) tiene una amplitud que corresponde a aproximadamente 2/3 la de la onda real, y que tiene una apariencia escalonada que no existe en la característica original. Aunque se distingue una onda, los detalles no están bien representados.

Si usamos esta representación para generar un pronóstico, surgirán problemas. Pongamos en marcha el modelo para ver la diferencia que se produce entre su representación y la característica real tras un breve período.

En 170 minutos la característica observada se mueve a razón de un ciclo completo de la onda. El pronóstico del modelo, sin embargo, presenta un retardo de fase considerable. La onda del modelo se ensancha y pierde amplitud. El resultado es un pronóstico de calidad inferior de esta característica.

3. Una malla de 20 km representa con precisión las características de 40 km » Características de escala más grande en los modelos numéricos

¿Cómo se compara esto con como el modelo maneja una característica de mayor escala, por ejemplo, una que abarca 10 puntos de malla? Vamos a ver.

Esta onda representa una característica de 10 ΔX que podría ser, por ejemplo, una estela de humedad que abarca 200 km en la misma malla de 20 km. El modelo representa esta característica de forma mucho más fina de lo que vimos con el ejemplo de 4 ΔX.

Si animamos el modelo, podemos ver que la onda 10 ΔX conserva mucho mejor la definición de la fase y la amplitud de la característica durante el mismo intervalo de tiempo. En general, el pronóstico de esta característica es mucho mejor que el de la onda 4 ΔX.

Aunque los detalles de retardo de fase, ensanchamiento de la onda y retención de la amplitud difieren de un modelo a otro, no existe ningún modelo capaz de reproducir con exactitud una característica 4 ΔX o menor. Sin embargo, una característica 10 ΔX se representará bien, e inicialmente se representarán bastante bien hasta las características que abarcan de 6 a 8 puntos de malla. Pero como veremos en el próximo ejemplo, con el tiempo incluso las características de ese tamaño se deterioran en el pronóstico del modelo.

3. Una malla de 20 km representa con precisión las características de 40 km » El concepto de degradación

Para comprender mejor por qué los análisis se degradan con el tiempo, vamos a considerar la ecuación de onda empleada para representar una característica. Esta onda representa una característica 7 ΔX, un vórtice de mesoescala que abarca 140 km en una malla de 20 km.

La representación inicial se compara bastante bien con la característica real, pero una vez puesta en marcha podemos ver que la onda se degrada con el paso del tiempo. Queda atrás respecto de la característica real, pierde amplitud y crea el comienzo de un pequeña onda de arrastre.

Esta simple ecuación de pronóstico muestra la relación entre la velocidad de cambio local de la variable T y la correspondiente advección causada por el viento. A partir de la ecuación podemos ver que el término de advección contiene el gradiente de T que, para que el modelo pueda generar un pronóstico adecuado, se debe representar con exactitud como una diferencia espacial finita en el modelo.

Si nos fijamos en el tercer punto de malla, podemos ver que el gradiente del modelo (la pendiente de la línea verde entre el segundo y cuarto puntos de malla) se desvía del gradiente real (la línea azul) en ese punto. De hecho, el gradiente real, que es la pendiente de la onda en el punto de malla 3, es mayor.

Al ejecutar el modelo, la discrepancia entre el gradiente representado y el gradiente verdadero aumenta rápidamente y el pronóstico se degrada, alejándose de la realidad.

En fin, cuantos más puntos de malla (cuanto menor el valor ΔX), tanto más puede el modelo acercarse a una representación fiel de los fenómenos atmosféricos y, como resultado, mantener un pronóstico más exacto. Cuanto mayor ΔX, menos puntos de malla habrá para representar la característica y, por tanto, tanto más rápido se degradará el pronóstico.

3. Una malla de 20 km representa con precisión las características de 40 km » Ponga a prueba sus conocimientos

Terminología para estas preguntas:

Resuelto/a significa que inicialmente la característica existe en el modelo numérico con una escala, ubicación y amplitud aproximadamente correctas, aunque no necesariamente con el grado de definición suficiente para que ese modelo pueda pronosticarla con precisión. Los modelos de PNT pueden resolver características que abarcan aproximadamente cuatro veces la distancia entre puntos de malla. Si una característica abarca menos de cuatro puntos de malla, quedará "escalonada" o mal definida , lo cual significa que se interpretará incorrectamente en términos de una longitud de onda mayor de la que tiene en la realidad.

Bien pronosticado/a significa que el análisis inicial del modelo resuelve la característica con una definición suficiente como para que esta se lleve hacia adelante en el tiempo de modo que tenga un grado razonable de precisión en la integración subsiguiente del modelo. Una característica se considera bien pronosticada si abarca al menos 8 a 10 puntos de malla.

Pregunta 1

Supongamos que está trabajando con un modelo numérico que tiene una malla de 12 km.

¿Podría este modelo resolver una onda corta en el nivel de 500 hPa? ¿Estaría bien pronosticada?

Explicación

Una onda corta es un fenómeno dinámico que existe y se desplaza en la atmósfera en diversos niveles. Podemos concebir una onda corta en el nivel de 500 hPa en términos de la ecuación de onda que estudiamos antes en esta sesión. Como típicamente las ondas cortas en el nivel de 500 hPa abarcan una escala horizontal de cientos de kilómetros, en un modelo de 12 km no solo se resolverían, sino que estarían bien pronosticadas.

Pregunta 2

Supongamos que está trabajando con un modelo numérico que tiene una malla de 12 km.

¿Se resolvería una brisa lacustre en la costa del Lago Superior? ¿Estaría bien pronosticada?

Explicación

Los fenómenos tales como la brisas lacustres y marinas y los vientos de valle deben su origen a las diferencias topográficas o entre zonas de tierra y agua, aunque una vez creadas las condiciones propicias, también tienen un componente dinámico en la atmósfera. Una brisa lacustre en la costa del Lago Superior puede extenderse una buena distancia a lo largo del litoral, y su escala perpendicular a la costa puede abarcar unas decenas de kilómetros sobre tierra y otros tantos sobre la superficie del agua. Willet y Sanders (Willet, H. C. y F. Sanders, 1959: Descriptive Meteorology. Academic Press. 355 págs.) explicaron que «al atardecer, la brisa de mar llega a su mayor alcance, adquiriendo a veces una extensión de hasta 30 millas tierra adentro y otras tantas sobre el mar». Esta escala horizontal, que equivale a una extensión total de aproximadamente 100 km, parece ser un límite máximo para las brisas marinas. Suponiendo una brisa lacustre de 50 km a lo ancho (lo cual abarca unos cuatro puntos de malla) en el momento de inicio del modelo de 12 km, esta brisa se resolvería (suponiendo una buena definición del límite tierra-agua en el modelo). Sin embargo, esta brisa es un fenómeno demasiado pequeño para que el modelo pueda pronosticarla bien. Las brisas de los lagos menores, o el comienzo de una brisa lacustre del Lago Superior, abarcarían zonas de mucho menos de 50 km de ancho. Una brisa lacustre con alcance de 20 km de ancho en el momento de inicio del análisis abarcaría menos de dos puntos de malla del modelo, de modo que probablemente existiría en el modelo, pero estaría mal definida y se representaría incorrectamente al comienzo. Esta brisa no estaría ni bien resuelta ni bien pronosticada en el modelo.

Anécdota

«El modelo LFM que se utilizaba en la década de 1980 y al comienzo de los años 90 tenía una separación entre puntos de malla superior a 100 km, una resolución horizontal muy gruesa en comparación con lo que consideramos la norma hoy en día. A veces, este modelo producía brisas lacustres para los lagos Superior y Michigan. Las brisas generadas por el modelo convergían luego sobre Eau Claire, Wisconsin, y el movimiento vertical resultante podía a su vez hacer que del modelo pronosticara precipitación para dicha ciudad. Esto resultaba totalmente fuera de lo real; el modelo sí incluía brisas lacustres, pero se equivocaba por completo en cuanto al detalle de sus dimensiones y su posición. Los modernos modelos de mayor resolución manejan las brisas lacustres mejor que el modelo LFM, aunque todavía no podemos contar con ellos para obtener los detalles correctos en cuanto a su alcance y ubicación».

Pregunta 3

Supongamos que está trabajando con un modelo numérico que tiene una malla de 12 km.

¿Se pronosticaría bien la precipitación orográfica relacionada con un fuerte flujo sinóptico del suroeste proveniente del Pacífico hacia la costa de Columbia Británica, en Canadá? ¿Qué escala se necesitaría?

Explicación

El fenómeno de precipitación orográfica está vinculado directamente a la topografía, a través de su interacción con el flujo de escala sinóptica prevaleciente. Aparte de esta interacción, no hay factores de dinámica atmosférica que causen el movimiento o la intensificación del área de precipitación. La precipitación coincidirá siempre con la topografía. Por lo tanto, si el flujo sinóptico se maneja correctamente, la precipitación orográfica se pronosticará bien hasta el límite del tamaño de la malla y de la topografía del modelo (resolución de 12 km). En estos casos, la característica no tiene que abarcar de 8 a 10 puntos de malla para que se pronostique bien.

3. Una malla de 20 km representa con precisión las características de 40 km » La realidad

En resumidas cuentas, los modelos de alta resolución no pueden resolver las características de pequeña escala. Estos modelos deben tener una resolución apropiada para la escala de las características que se incluirán en la representación numérica.

El factor más importante que determina la calidad de la resolución de una característica atmosférica es su tamaño en comparación con el tamaño de la malla del modelo. Aunque inicialmente las características que abarcan menos de 8 a 10 puntos de malla pueden representarse bastante bien, se degradarán rápidamente en cualquier modelo. En cuanto a las características de pequeña escala, como las brisas marinas, la nieve por efecto lago y los vientos orográficos, no hay forma de que un modelo de PNT los maneje correctamente a menos que abarquen de 8 a 10 puntos de malla. En un modelo de alta resolución con un valor ΔX de 10 km, ¡las características deben abarcar más de 80 km para resolverse bien y conservarse durante la integración del modelo!

Resumen

- Un factor clave que determina si una característica se puede resolver es su tamaño en comparación con la distancia entre puntos de malla.

- Los fenómenos atmosféricos deben ser al menos 8 veces mayores que la distancia entre puntos de malla (ΔX) para resolverse bien y conservarse por un período de pronóstico razonable.

Para aprender más acerca de este tema, consulte la sección «Resolución horizontal»

de la lección Impacto de la estructura y dinámica de los modelos, versión 2 que

forma parte del curso de educación a distancia sobre la PNT.

4. Las condiciones de superficie están representadas con precisión

- El concepto equivocado

- Campos de superficie en el modelo Eta

- Campos de superficie en el modelo GEM

- Comparación de los campos de superficie de los modelos Eta y GEM

- Ejemplo de fracción de vegetación verde en el modelo Eta

- Impacto de la vegetación

- Efectos de la vegetación en un modelo de una columna

- Ponga a prueba sus conocimientos

- La realidad

4. Las condiciones de superficie están representadas con precisión » El concepto equivocado

Sería fácil suponer que los avanzados sistemas de PNT en uso hoy en día siempre representan correctamente las condiciones de superficie. Por ejemplo, que el modelo siempre sabe exactamente donde hay nieve en el suelo, que cuenta con los datos del estado actual de la vegetación, que utiliza valores analizados y exactos de la humedad del suelo y que, en caso de crecidas, define las zonas de terreno inundado.

No necesariamente. Aunque los modelos de PNT modernos incorporan tratamientos avanzados de las condiciones de superficie, en ciertas situaciones los pronósticos que generan requieren reajustes considerables, debido a las imprecisiones incluidas en las definiciones iniciales de las condiciones de superficie que emplea el modelo, o bien a ciertas debilidades en su forma de manejar dichas condiciones.

4. Las condiciones de superficie están representadas con precisión » Campos de superficie en el modelo Eta

En primer lugar, consideremos cómo dos modelos de PNT operativos, el modelo Eta para EE. UU. y el modelo GEM regional canadiense, manejaban los parámetros de vegetación y humedad del suelo en la primavera de 2002.

Comencemos con el modelo Eta.

Para los tipos de vegetación, el modelo Eta emplea una climatología mundial de tipos de vegetación de un grado por un grado. Los valores de cada celda del modelo Eta se derivan del punto medio de un grado por un grado más cercano. La resolución de este conjunto de datos de tipos de vegetación es mucho más gruesa que la resolución del modelo Eta, y esto puede generar errores en cuanto al tipo de vegetación en el modelo. La fracción de cubierta vegetal, o fracción de vegetación verde, es la porción de cada celda del modelo que está cubierta por vegetación viva. Los datos de fracción de cubierta vegetal empleados en el modelo Eta se basan en un conjunto de datos de índice de vegetación de diferencia normalizada, o IVDN (que también se conoce por su sigla en inglés NDVI, es decir, Normalized Difference Vegetation Index), obtenido por percepción remota entre 1985 y 1989, que tiene una resolución de 0,144 grados. La fracción de cubierta vegetal real puede estar adelantada o retrasada con respecto a esta climatología.

Para especificar la humedad del suelo, la superficie terrestre del modelo Eta está acoplada a un modelo del suelo de cuatro capas. Durante el ciclo de asimilación del modelo Eta, que comienza 12 horas antes de su momento inicial, se utilizan análisis de la precipitación efectuados con datos de radar y pluviómetros del territorio continental de EE. UU. y del sur de Canadá, cerca de la frontera entre dichos países, para efectuar pequeñas correcciones en la precipitación prevista por el modelo Eta con el fin de que se acerque a los valores observados. Esto produce un análisis de la precipitación similar a lo observado que luego se utiliza en el modelo de la superficie del suelo. El resultado de este modo de proceder es que la humedad del suelo está más o menos ligada a la precipitación observada en el área comprendida dentro del límite marcado por la línea azul en el mapa que aparece a continuación. Nunca se utilizan valores reales de humedad del suelo. En la gran mayoría de los lugares en Canadá y en Alaska, la precipitación empleada para establecer la humedad del suelo proviene directamente del modelo Eta, sin las pequeñas correcciones efectuadas con las observaciones. En esas áreas, por tanto, la humedad del suelo está ligada a la precipitación pronosticada por el modelo Eta.

4. Las condiciones de superficie están representadas con precisión » Campos de superficie en el modelo GEM

Vamos a ver ahora cómo se tratan los parámetros de vegetación y humedad del suelo en el modelo GEM regional, en el cual se utiliza un esquema de interacción suelo-vegetación-atmósfera denominado ISBA (Interactions among the Soil, Biosphere and Atmosphere) para manejar los procesos superficiales.

Los tipos de vegetación utilizados en el esquema ISBA sobre América del Norte provienen de una base de datos climatológica del Servicio Geológico de los Estados Unidos (USGS) organizada sobre una malla de 1 km por 1 km que incluye 24 tipos de vegetación. En el modelo, las características de vegetación tales como índice de área foliar, fracción de cubierta vegetal y profundidad radicular cambian de un día para otro de acuerdo con una tabla predefinida. Las variables de vegetación se promedian en el espacio para que el modelo GEM cuente con valores representativos para el área de sus celdas. Debido a que se emplean valores climatológicos, es posible que las condiciones de vegetación reales no coincidan con las que supone el modelo.

ISBA emplea un modelo de humedad del suelo de dos niveles. Una vez al día, a las 00 UTC, se aplica una técnica denominada asimilación secuencial que utiliza un procedimiento de retroalimentación de errores para modificar los campos de humedad del suelo en la malla del modelo por medio de los errores generados por el modelo GEM en los pronósticos de temperatura del aire y humedad relativa a dos metros de altura (la altura normal de las garitas meteorológicas). No se utiliza ninguna medida real de la humedad del suelo.

Tanto el modelo GEM regional como el modelo Eta calculan la evaporación y evapotranspiración de la superficie en función de sus características de humedad del suelo y vegetación.

4. Las condiciones de superficie están representadas con precisión » Comparación de los campos de superficie de los modelos Eta y GEM

Eta

Vegetación

Para los tipos de vegetación, el modelo Eta emplea una climatología mundial de tipos de vegetación de un grado por un grado. Los valores de cada celda del modelo Eta se derivan del punto medio de un grado por un grado más cercano. La resolución de este conjunto de datos de tipos de vegetación es mucho más gruesa que la resolución del modelo Eta, y esto puede generar errores en cuanto al tipo de vegetación en el modelo. La fracción de cubierta vegetal, o fracción de vegetación verde, es la porción de cada celda del modelo que está cubierta por vegetación viva. Los datos de fracción de cubierta vegetal empleados en el modelo Eta se basan en un conjunto de datos de índice de vegetación de diferencia normalizada, o IVDN (que también se conoce por su sigla en inglés NDVI, es decir, Normalized Difference Vegetation Index), obtenido por percepción remota entre 1985 y 1989, que tiene una resolución de 0,144 grados. La fracción de cubierta vegetal real puede estar adelantada o retrasada con respecto a esta climatología.

Humedad del suelo

Para especificar la humedad del suelo, la superficie terrestre del modelo Eta está acoplada a un modelo del suelo de cuatro capas. Durante el ciclo de asimilación del modelo Eta, que comienza 12 horas antes de su momento inicial, se utilizan análisis de la precipitación efectuados con datos de radar y pluviómetros del territorio continental de EE. UU. y del sur de Canadá, cerca de la frontera entre dichos países, para efectuar pequeñas correcciones en la precipitación prevista por el modelo Eta con el fin de que se acerque a los valores observados. Esto produce un análisis de la precipitación similar a las cantidades observadas que luego se utiliza en el modelo de la superficie del suelo. El resultado de este modo de proceder es que la humedad del suelo está más o menos ligada a la precipitación observada en el área comprendida dentro del límite marcado por la línea azul en el mapa que aparece a continuación. Nunca se utilizan valores reales de humedad del suelo. En la gran mayoría de los lugares en Canadá y en Alaska, la precipitación empleada para establecer la humedad del suelo proviene directamente del modelo Eta, sin las pequeñas correcciones efectuadas con las observaciones. En esas áreas, por tanto, la humedad del suelo está ligada a la precipitación pronosticada por el modelo Eta.

Nieve

Los valores de manto de nieve y profundidad de la nieve para el modelo Eta provienen de un análisis diario del manto de nieve del servicio nacional de datos e información de satélites ambientales (National Environmental Satellite Data and Information Service, o NESDIS), que tiene una resolución de 23 km, que se fusiona con el análisis diario de la profundidad de la nieve de la agencia meteorológica de las fuerzas aéreas de EE. UU. (Air Force Weather Agency, o AFWA), con una resolución de 47 km, con validez a las 18 UTC. Ambos se basan en observaciones satelitales, y el análisis de AFWA utiliza también datos sinópticos de la profundidad de la nieve. Se realiza un control de calidad del análisis de AFWA frente a las observaciones de manto de nieve del NESDIS para el período aproximado entre las 18 y las 22 UTC con el fin de crear un análisis diario de la profundidad de la nieve de 0,5 x 0,5 grados válido a las 18 UTC. Dicho análisis se utiliza por primera vez cuando se ejecuta el modelo Eta a las 06 UTC y en las ejecuciones subsiguientes, a las 12, 18 y 00 UTC. Esto significa que cuando se utiliza a las 00 UTC, ya han transcurrido 30 horas desde que se realizó el análisis de nieve. La profundidad de la nieve es una variable dinámica en el modelo Eta y puede cambiar durante la integración del modelo.

Hielo

El análisis de manto de hielo del modelo Eta se basa exclusivamente en datos de satélite provenientes del grupo de análisis satelital (Satellite Analysis Branch, o SAB) que se actualizan una vez al día con validez a las 00 UTC, sobre una malla polar estereográfica con una resolución de 25,4 km exacta a 60 grados norte. Este análisis incluye datos para los Grandes Lagos. No se incluyen datos de espesor del hielo.

TSM

La temperatura de la superficie del mar se analiza en una malla de 0,5 x 0,5 grados utilizando los datos de 24 horas más recientes de las boyas y los buques, así como las temperaturas derivadas del satélite. La longitud de correlación de la técnica 2D-VAR empleada en este análisis es tal que tiende a preservar los detalles de TSM. Este análisis se actualiza una vez al día, a tiempo para la ejecución de las 00 UTC del modelo Eta.

GEM

Vegetación

En el modelo regional GEM, se utiliza un esquema de interacción de superficie del suelo-vegetación-atmósfera denominado ISBA (Interactions among the Soil, Biosphere and Atmosphere) para manejar los procesos superficiales. Los tipos de vegetación utilizados en el esquema ISBA sobre América del Norte provienen de una base de datos climatológica del Servicio Geológico de los Estados Unidos (USGS) organizada sobre una malla de 1 km por 1 km que incluye 24 tipos de vegetación. En el modelo, las características de vegetación tales como índice de área foliar, fracción de cubierta vegetal y profundidad radicular cambian de un día para otro de acuerdo con una tabla predefinida. Las variables de vegetación se promedian en el espacio para que el modelo GEM cuente con valores representativos para el área de sus celdas. Debido a que se emplea un esquema de climatología, es posible que las condiciones de vegetación reales no coincidan con las que supone el modelo.

Humedad del suelo

ISBA emplea un modelo de humedad del suelo de dos niveles. Una vez al día, a las 00 UTC, se aplica una técnica denominada asimilación secuencial que utiliza un procedimiento de retroalimentación de errores para modificar los campos de humedad del suelo en la malla del modelo por medio de los errores generados por el modelo GEM en los pronósticos de temperatura del aire y humedad relativa a dos metros de altura (la altura normal de las garitas meteorológicas). Esto se hace en toda América del Norte. No se utiliza ninguna medida real de la humedad del suelo.

Nieve

El análisis de profundidad de la nieve del Centro Meteorológico de Canadá es controlado por los pronósticos de precipitación y temperatura del modelo GEM global e incorpora todas las observaciones de profundidad de la nieve disponibles. Este análisis global se actualiza cada 6 horas, sobre una malla de latitud/longitud de 1/3 x 1/3 de grado. El análisis se interpola con la malla del modelo para proporcionar las condiciones de nieve iniciales, que nunca tienen más de 6 horas de antigüedad para la ejecución del modelo. La profundidad de la nieve es una variable dinámica en el modelo GEM regional y puede cambiar durante la integración del modelo.

Hielo

El análisis de manto de hielo del Centro Meteorológico de Canadá emplea los datos del sensor SSMI del satélite junto con los datos de las observaciones de hielo obtenidas por el servicio canadiense de hielo (Canadian Ice Service). Este análisis global se actualiza una vez al día sobre una malla gaussiana de 1/3 x 1/3 de grado que incorpora todos los datos sobre hielo recibidos durante el período de 24 horas que termina a las 00 UTC. También se utilizan las observaciones de manto de hielo para 118 lagos canadienses tomadas por el Canadian Ice Service, aunque solo están disponibles una vez a la semana. Este análisis no incluye datos de espesor del hielo.

TSM

La temperatura de la superficie del mar se analiza en el Centro Meteorológico de Canadá sobre una malla de latitud-longitud global con una resolución de 37 km. El análisis se actualiza una vez al día a las 00 UTC e incorpora los datos de las 24 horas anteriores tomados por satélites, buques y boyas. Cuando no se cuenta con observaciones, el análisis de TSM vuelve despacio a la climatología. Aunque esto no representa un problema sobre los océanos, sí puede llevar a errores sobre los lagos de Canadá si no hay observaciones de las temperaturas de los lagos. A excepción de los Grandes Lagos, dichas observaciones son escasas.

4. Las condiciones de superficie están representadas con precisión » Ejemplo de fracción de vegetación verde en el modelo Eta

¿Cómo pueden los campos de superficie afectar los pronósticos del modelo? A modo de ejemplo, consideremos cómo el modelo Eta tiene en cuenta la fracción de cubierta vegetal o vegetación verde.

Fíjese en esta serie de imágenes que representan la fracción de cubierta vegetal de EE. UU., el sur de Canadá y partes de México y el Caribe. De forma específica, vamos a observar dos zonas dedicadas principalmente a cultivos: la banda de trigo de invierno entre Kansas y Oklahoma y la zona de cultivo de maíz del Medio Oeste de EE. UU.

En enero, mucho del territorio interno y al norte de 35 grados carece de vegetación, a excepción de la banda de trigo de invierno (centrada cerca de 37N y 98O), donde se sembró el trigo de invierno el otoño anterior.

En abril la banda de trigo de invierno alcanza su máximo verdor, pero la mayoría de las demás zonas recién comienzan a verdear. La zona de cultivo de maíz representa una excepción, ya que queda relativamente marrón en comparación con las áreas circundantes. Estas otras áreas están cubiertas de árboles caducifolios.

En los meses de verano, se cosecha el trigo de invierno, lo cual crea un área marrón en esa zona, mientras que las regiones de bosque del centro y este de los EE. UU. alcanzan su máximo verdor. La banda de cultivo de maíz sigue relativamente marrón hasta julio, cuando se produce una explosión repentina de vegetación a medida que el maíz crece y madura.

En otoño, se cosecha el maíz y ya para octubre la zona se ha vuelto marrón. Mientras tanto, los bosques también comienzan a cambiar de color, y se siembra el trigo de invierno para la cosecha del año siguiente, y así comienza otra vez el mismo ciclo.

El impacto de estos cambios estacionales en la fracción de vegetación verde puede ser considerable. A continuación veremos cómo estos cambios afectan los modelos.

4. Las condiciones de superficie están representadas con precisión » Impacto de la vegetación

¿Por qué importa la cantidad de vegetación verde que se considera en un modelo de predicción numérica del tiempo? Porque este factor influye de forma considerable en los flujos de calor sensible y latente en los niveles inferiores, lo cual a su vez determina la temperatura y humedad atmosférica en los niveles inferiores.

La vegetación verde afecta los niveles de humedad, porque controla la cantidad de evaporación. La vegetación extrae agua de las capas subsuperficiales del suelo y luego, durante el día, devuelve esa agua a la atmósfera, por transpiración.

La vegetación también afecta los niveles de energía en la superficie. Cuando hay vegetación, parte de la energía que de otro modo calentaría la superficie directamente pasa al proceso de evapotranspiración, lo cual tiene enormes consecuencias para la temperatura y humedad de superficie, y la temperatura, humedad y estabilidad estática de la capa límite planetaria.

4. Las condiciones de superficie están representadas con precisión » Efectos de la vegetación en un modelo de una columna

Para ilustrar el impacto de la vegetación en la temperatura de superficie, hemos usado un modelo de una columna para representar una única celda y hemos ejecutado dos casos para un ciclo diurno completo. Los modelos de una columna se utilizan con frecuencia para validar las parametrizaciones físicas de los modelos de PNT.

En este ejemplo, el forzamiento para los dos casos es idéntico y proviene de los datos observados en junio de 1997 en una zona de prueba para nubes y radiación atmosférica en la región al sur de las Grandes Llanuras. La parametrización física bajo estudio es la que utilizan los modelos GFS/AVN y MRF. La única diferencia entre los dos casos es la cantidad de vegetación en la celda. En lo que denominaremos el caso «precosecha», el 90 % de la celda está cubierto por vegetación de cultivo, mientras que en el caso «postcosecha» solo el 20 % contiene vegetación verde. Los gráficos que siguen muestran los ciclos diurnos que resultan para las temperaturas de superficie y cerca de la superficie.

Arriba puede ver el ciclo diurno del caso «precosecha». La temperatura de la capa superficial pronosticada se da en gris, la temperatura diagnosticada para el nivel de 2 metros aparece en verde y la temperatura prevista para el nivel de 995 hPa está en amarillo. El gráfico de abajo presenta las mismas variables para el caso «postcosecha».

Hay una clara diferencia en los ciclos diurnos de los dos casos. Las temperaturas después de la cosecha son de 5 a 6 grados Celsius más altas que antes de la cosecha. Aunque no se muestran, las diferencias en la humedad y las características de la capa límite planetaria presentan el mismo grado de diferencia.

Debido a que por lo general para parametrizar la convección en los modelos de PNT se emplean los parámetros de estabilidad de la capa límite planetaria o de la parcela de superficie, se deduce de esto que los errores en la fracción de cubierta vegetal del modelo pueden causar errores en la iniciación de la actividad convectiva.

Para los pronósticos a nivel regional, es importante saber si el estado real de la vegetación coincide con la fracción de vegetación verde actual utilizada en el modelo. Según la medida en que coincidan, la salida del modelo puede o no necesitar ajustes considerables antes de utilizarse en un pronóstico.

4. Las condiciones de superficie están representadas con precisión » Ponga a prueba sus conocimientos

Debido a condiciones primaverales muy cálidas y húmedas, los campos y los bosques del área de pronóstico han verdecido mucho antes de lo acostumbrado. ¿Cómo podría esto influir en sus predicciones de los parámetros de superficie para una situación de actividad convectiva de sector cálido que se aproxima? Seleccione una opción para cada parámetro y después haga clic en Terminado para ver los resultados.

Pregunta 1

Para la temperatura máxima de superficie, conviene:

La respuesta correcta es d)

En este caso, el modelo cuenta con considerablemente menos vegetación de lo que realmente existe. El resultado es que las temperaturas máximas del modelo serán demasiado altas a razón de varios grados C, porque el modelo usará gran parte de la radiación solar entrante para calentar la superficie del suelo en lugar de asignarla a la evapotranspiración a través del dosel de la vegetación.

Pregunta 2

Para la profundidad de la capa límite planetaria (CLP), conviene:

La respuesta correcta es b)

Debido a la superficie terrestre más fresca que resulta del aumento en la evaporación, la profundidad de la CLP será menor de lo que pronostica el modelo.

Pregunta 3

Para los vientos y la turbulencia cerca de la superficie, conviene:

La respuesta correcta es b)

Cuando la superficie terrestre es más fresca, se produce menos mezcla turbulenta en la CLP, lo cual a su vez reduce la transferencia por momento hacia abajo desde los niveles arriba de la superficie, donde los vientos son más fuertes, y por eso en este caso los vientos de superficie son más débiles.

Pregunta 4

Para la humedad relativa, conviene:

La respuesta correcta es b)

Cuanto mayor la evapotranspiración de las plantas, tanto mayor la humedad cerca de la superficie y dentro de la CLP. Por lo tanto, el modelo calcula un nivel de HR demasiado bajo en la CLP. Debido a la turbulencia menos intensa en la CLP, producto de las temperaturas de superficie más bajas, la humedad no se mezcla hacia arriba hasta alcanzar alturas tan altas como en el caso más cálido, en el que había pocas plantas. Esto significa que la HR real cerca de la CLP y arriba de ella será menor de lo que pronostica el modelo en esta situación.

Pregunta 5

En esta situación, ¿debería la probabilidad de que se produzca precipitación convectiva...

La respuesta correcta es c)

Cuando la cubierta vegetal alcanza el máximo, la temperatura en los niveles inferiores es menor de lo que pronostica el modelo. En términos de energía convectiva potencial disponible, los dos efectos actúan en direcciones opuestas, de forma que no queda claro de antemano cuál puede ser el resultado neto. Lo que puede hacer es crear un sondeo de pronóstico modificado basado en la mejor estimación posible de la temperatura y el punto de rocío esperados en los niveles inferiores y juzgar el potencial de convección de la situación a partir de dicho sondeo.

Pregunta 6

Supongamos que a las 00 UTC el suelo sobre el sur de Saskatchewan está despejado, pero después se produce una nieve fuerte y durante el período de 01 a 05 UTC se observa un manto de nieve en varias estaciones. ¿Cuál es el primer momento en que cada uno de estos modelos «verá» esta capa de nieve?

El análisis canadiense de la profundidad de la nieve se actualiza cada 6 horas. El análisis de las 18 UTC termina antes de que se ejecute el modelo a las 00 UTC, y se utiliza para ese procesamiento. De forma análoga, el análisis de las 06 UTC se utiliza cuando se ejecuta el modelo a las 12 UTC. Los modelos GEM nunca están más de 6 horas atrás en cuanto a la profundidad de nieve que «ven» cuando se inicializan a las 12 y a las 00 UTC. El análisis de nieve empleado por el modelo Eta se actualiza una vez al día de acuerdo con los datos de profundidad de la nieve de la USAF de las 18 UTC y se somete a un control de calidad mediante las observaciones de manto de nieve de NESDIS de las 18 a 22 UTC. El manto de nieve se «verá» por primera vez al procesar el modelo Eta a las 06 UTC. Esto significa que cuando se ejecuta el modelo a las 00 UTC, el análisis de nieve caída es de casi 30 horas antes. El modelo Eta no «verá» la nieve del período de las 01 a las 05 UTC hasta la próxima vez que se procese a las 06 UTC, más de 24 horas más tarde.

Pregunta 7

¿En cuál(es) de los modelos (GEM regional; GEM global; Eta) es la profundidad de la nieve una variable dinámica (que cambia con el tiempo) durante el proceso de integración del modelo?

La respuesta correcta es d)

Este es un ejemplo de cómo las integraciones de los distintos modelos pueden manejar los procesos superficiales de forma diferente. A partir de la primavera de 2002, los modelos GEM regional y Eta emplean esquemas dinámicos de profundidad de la nieve. El modelo GEM global, por otra parte, «veía» el análisis inicial de nieve, pero lo mantenía constante durante la totalidad de la integración. Esto cambiará en el futuro, cuando se conecte el sistema ISBA al modelo GEM global.

4. Las condiciones de superficie están representadas con precisión » La realidad

En resumen, las condiciones de superficie iniciales no se representan necesariamente con exactitud en cada ejecución del modelo. Esto puede deberse al uso de campos de superficie climatológicos, así como a factores tales como el momento, la técnica, la resolución, la disponibilidad de los datos y los esquemas de control de calidad de las rutinas empleadas para analizar los campos de superficie.

Además de los potenciales problemas de análisis, es preciso recordar que los procesos superficiales no se modelan de forma exacta, sino que se aproximan y pueden existir fuertes relaciones de dependencia entre los distintos procesos. Además, no solo pueden los distintos modelos numéricos usar análisis iniciales diferentes de los campos de superficie, sino que normalmente dichos campos de superficie se manejan de forma distinta dentro de sus propias integraciones. Estas realidades garantizan un alto grado de complejidad en lo referente a los campos de superficie y procesos en los modelos de PNT.

Por lo general, para comprender cómo los campos de superficie pueden estar desviándose de la realidad es preciso saber cómo se recopilan los datos de los campos de superficie y cómo se incorporan en los modelos de PNT. Comprender estos procesos ayuda a evaluar mejor la salida del modelo y a efectuar ajustes adecuados en el pronóstico.

En realidad, las condiciones de superficie más recientes de un modelo de PNT pueden:

- basarse en la climatología;

- no coincidir con la escala de la malla del modelo;

- no llegar a formar parte de los parámetros de la ejecución actual del modelo;

- no haberse analizado adecuadamente;

- no haberse manejado correctamente en la integración del modelo.

Para aprender más acerca del tratamiento y los efectos de los distintos campos de superficie, consulte la lección de COMET titulada Impacto de la física del modelo en los pronósticos numéricos, versión 2.

Además de las descripciones de los campos de superficiedescripciones de los campos de superficie que aparecen en esta página, encontrará información al día acerca de estas y muchas otras características de los modelos en la Enciclopedia de Modelos Operativos (Operational Models Encyclopedia).

5. Esquema de PC 1: la precipitación convectiva se parametriza directamente

- El concepto equivocado

- Secuencia de desarrollo natural de un episodio convectivo

- Secuencia de desarrollo de un episodio convectivo en un modelo sin parametrización de la convección

- Esquemas de ajuste

- Esquemas de flujo de masa

- Compensación de los puntos débiles de los esquemas de parametrización de la convección

- Ponga a prueba sus conocimientos

- La realidad

5. Esquema de PC 1: la precipitación convectiva se parametriza directamente » El concepto equivocado

Como predecir la convección y la precipitación resultante forma parte integral de muchos pronósticos, parecería lógico pensar que el objetivo principal de un esquema de parametrización de la convección es pronosticar la precipitación convectiva.

La verdad es que la precipitación es un producto secundario del esquema de parametrización de la convección del modelo, cuyo verdadero objetivo es descargar la inestabilidad para que el modelo no pronostique convección a escala de malla: no sería conveniente, por ejemplo, que un modelo AVN con una malla de 80 km generase una corriente ascendente convectiva de 80 km de ancho, algo que no se ajustaría en absoluto a la realidad.

5. Esquema de PC 1: la precipitación convectiva se parametriza directamente » Secuencia de desarrollo natural de un episodio convectivo

Claramente, los modelos de PNT deben tener en cuenta la convección de alguna manera.

Para hacerlo, utilizan parametrizaciones que tratan de reproducir el ciclo de vida natural de un episodio de desarrollo convectivo. ¿Qué puede ocurrir en un modelo que no usa un esquema de parametrización de la convección? Para contestar esa pregunta, vamos a comparar una secuencia natural de desarrollo convectivo con la que produciría un modelo sin parametrización de la convección.

Consideremos en primer lugar el ciclo de vida natural de un clásico episodio de desarrollo convectivo, tal como aparecería en la columna de una celda de la malla del modelo.

Nuestro punto de partida es un sondeo de condiciones inestables favorables para el desarrollo de convección. A medida que la nube se desarrolla, una fuerte corriente ascendente que solo ocurre en una pequeña parte de la columna transporta rápidamente el calor y la humedad a la troposfera superior. También se produce una subsidencia compensadora más débil fuera de la corriente ascendente, pero aún dentro de la columna. Aunque llueve en una pequeña parte de la celda, en el resto de la celda no se produce precipitación. Cuando la convección se debilita, puede caer lluvia de la nube estratiforme en los niveles medios y superiores. El resultado final es una atmósfera estable después de la actividad convectiva.

5. Esquema de PC 1: la precipitación convectiva se parametriza directamente » Secuencia de desarrollo de un episodio convectivo en un modelo sin parametrización de la convección

Vamos a ver ahora como un modelo sin parametrización de la convección manejaría el mismo evento.

A partir del mismo sondeo de condiciones inestables, en el modelo la convección se acumula debido a velocidades verticales a escala de malla. Como estas velocidades son muy bajas en comparación con las corrientes convectivas ascendentes que se producen en la realidad (a nivel de centímetros por segundo), la nube crece lentamente.

Un resultado de esta acumulación lenta es el retardo del comienzo de la precipitación en comparación con el evento natural. Además, a medida que la secuencia progresa el modelo crea precipitación fuerte en la totalidad de la celda y la nube no alcanza la extensión en altura que sería natural. Finalmente, la columna entera se satura completamente en toda la extensión de la nube del modelo.

Esto provoca la liberación de una gran cantidad de calor latente en la troposfera inferior y media en la fase madura de la nube convectiva, lo cual a su vez puede ocasionar la formación de un centro de baja presión en la superficie.

En la fase posconvección del modelo, el centro de baja presión en la superficie persiste y buena parte del sondeo está casi saturado. Estas condiciones pueden fácilmente conducir a más precipitación en el modelo.

Claramente, un modelo que se ejecuta sin un esquema de parametrización de la convección no tiene posibilidad alguna de producir un buen pronóstico de precipitación. Es más, puede incluso crear una onda frontal excesivamente desarrollada o un centro de baja presión demasiado profundo en la superficie. Los modelos de PNT deben usar esquemas de parametrización de la convección para poder evitar estos problemas.

5. Esquema de PC 1: la precipitación convectiva se parametriza directamente » Esquemas de ajuste

Esencialmente, los esquemas de parametrización de la convección cambian la distribución del calor y la humedad para contrarrestar la tendencia de los modelos a generar convección a escala de malla.